Te presentamos las últimas actualizaciones sobre las ayudas de...

Abrazar la innovación es fundamental para impulsar la competitividad empresarial; sin embargo, en...

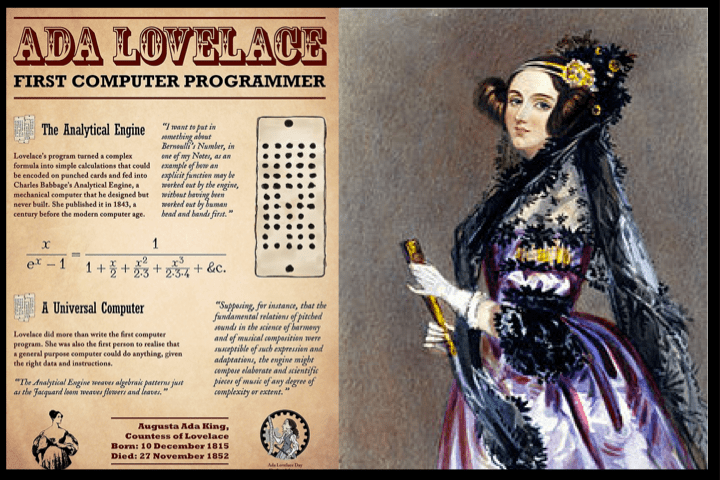

Augusta Ada King, Condesa de Lovelace (1815-1852), matemática, informática y escritora británica, célebre por su trabajo acerca de la calculadora de uso general de Charles Babbage, tenía entre sus notas lo que se reconoce hoy como el primer algoritmo destinado a ser procesado por una máquina, por lo que se la considera como la primera programadora de ordenadores. Ada describió con detalle las operaciones mediante las cuales las tarjetas perforadas “tejerían” una secuencia de números en la máquina analítica. Este código está considerado como el primer algoritmo específicamente diseñado para ser ejecutado por un ordenador.

Dedujo y previó la capacidad de los ordenadores para ir más allá de los simples cálculos de números. Lo que no podría imaginarse es que la Inteligencia Artificial la podría discriminar en un proceso de selección para Amazon si viviera hoy en día, pero que sufrirían sus generaciones venideras, o que los resultados de la búsqueda en Google con las palabras ‘algoritmo’ y ‘mujer’ se centrarían, casi únicamente sobre la existencia del sesgo de género en los algoritmos.

Existe una brecha de género así, como racial, y es innegable. Según el Informe DISCRIMINATING SYSTEMS de tres investigadoras de IA Now Institute y la New York University, el desastre de diversidad ahora alcanza a todo el sector de la IA, y es que “las estadísticas de diversidad de género y de raza son alarmantemente bajas”.

Estudios recientes encontraron que solo el 18% de los autores en las principales conferencias de IA son mujeres, y más del 80% de los profesores de IA son hombres. Esta disparidad es extrema en la industria de IA: las mujeres comprenden solo el 15% del personal de investigación de IA en Facebook y 10% en Google. Para los trabajadores de raza negra, la situación es aún peor. Por ejemplo, solo el 2.5% de la fuerza laboral de Google es de raza negra, mientras que Facebook y Microsoft tienen cada uno el 4%.

Con estos datos, lo único que me viene a la mente es pensar en qué soluciones se están poniendo a este problema que logre encontrar un camino positivo que nos lleve a un futuro inmediato que haga que esto cambie radicalmente. Se debe ampliar el marco de referencia e integrar enfoques sociales y técnicos. Si queremos que la IA sea complementaria a nuestro cerebro, pero ésta está limitada y sesgada, necesitamos desarrollar esta tecnología desde marcos éticos, y debe estar presente no solo en las respuestas, sino también en las preguntas.

Conocer los sesgos existentes en los datos de entrenamiento, ejercer un control sobre ello y extinguirlo. Traducido sería: no deberíamos permitir que las máquinas comentan los mismos errores que los humanos, ni que el sistema de IA esté sesgado. No deberían replicarse los prejuicios humanos a la hora de tomar decisiones. Y en cuatro palabras: justicia, responsabilidad, transparencia e igualdad, por favor.

Explore our latest insights

Abrazar la innovación es fundamental para impulsar la competitividad empresarial; sin embargo, en...

Un aspecto importante del aumento de la sostenibilidad en el sector aeroespacial es la transición...

El término ESG hace referencia a un conjunto de criterios y prácticas adoptados por empresas e in...

Como ya hemos hablado en alguna ocasión, el sistema de Certificados de Ahorro Energético (CAEs) h...